进阶!空间视频拍摄技巧分享

XR 基地是一个专注于 XR 领域的创作者社区,我们的目标是 让 XR 开发变得更简单!

如果您熟悉中文,您还可以通过以下方式找到我们:官方网站(CN), 微博, 即刻, 微信公众号, 稀土掘金。

本文的视频版 《不容错过的空间视频拍摄技巧分享》已经发布,欢迎大家前往 B 站一键三连

相信屏幕前的各位已经通过各类设备拍摄了一些空间视频,虽然现在可以通过解码的方式在一些 MR 设备上观看,但是有一些朋友反馈效果没有那么震撼。所以空间视频就是一个幌子?还是说,我们还需要一些特定的技巧?

答案当然是后者。目前,如果你拍摄的空间视频看起来没有那么的震撼,大概率会是下面两个原因导致的:

- 现在能买到的 MR 设备,在屏幕清晰度、音频系统以及内容呈现算法上都和 Vision Pro 有一定的差距。一个好的空间视频观看体验离不开视觉、听觉的的共同作用。

- 虽然 Apple 在 iPhone 上推出空间视频可能是希望大家随手就能拍摄,但是想要获得良好的观看体验,空间视频拍摄需要掌握一些门道。

那在这篇文章中,我们就来仔细讲讲,拍摄好空间视频应该掌握的一些门道。

先说结论,如果你想拍摄出具有较强立体感的空间视频,那你需要:

在某些重要画面,让拍摄主体落在距离镜头 5-10cm 的位置

那么,为什么用这个技巧就能够拍摄好空间视频?要解答这个问题,我们得先从空间视频的原理说起。

空间视频的立体感是利用双目视差来营造的,我们人天生就有感知深度和距离的能力,这与生俱来的能力,其背后的原理却是极其复杂的(甚至在学术上还存在争论)。简单来说,Apple Vision Pro 通过向两只眼睛传输稍有差异的图片来模拟我们人眼的成像过程:即组合两只眼睛的视网膜上的二维图像,感知世界的三维信息。

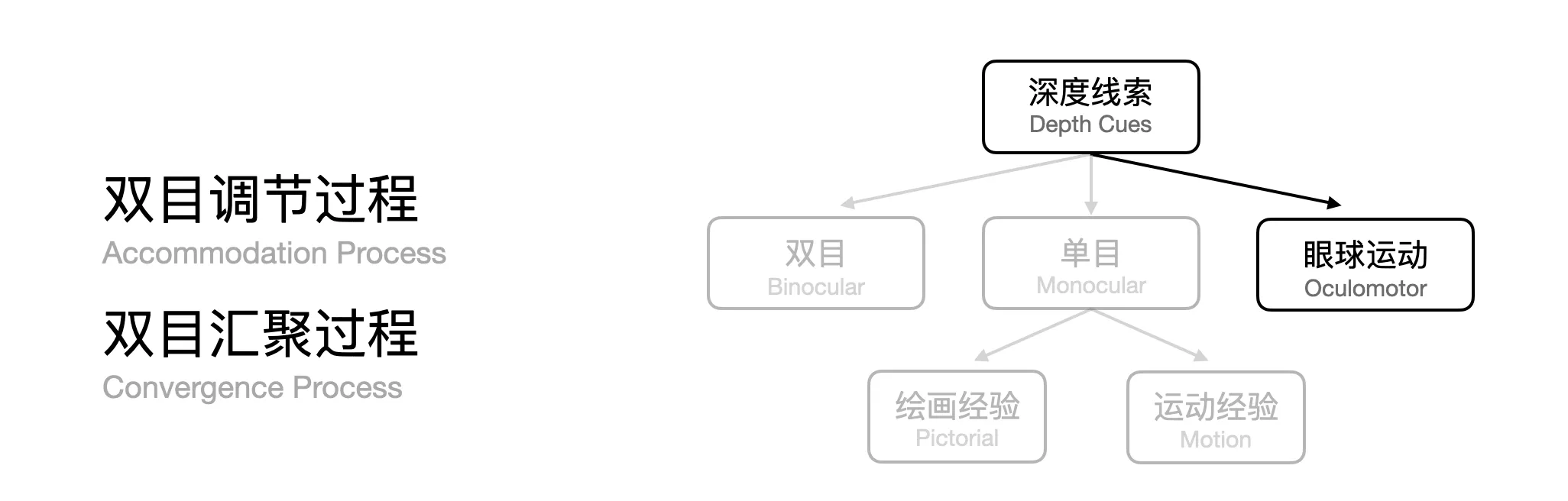

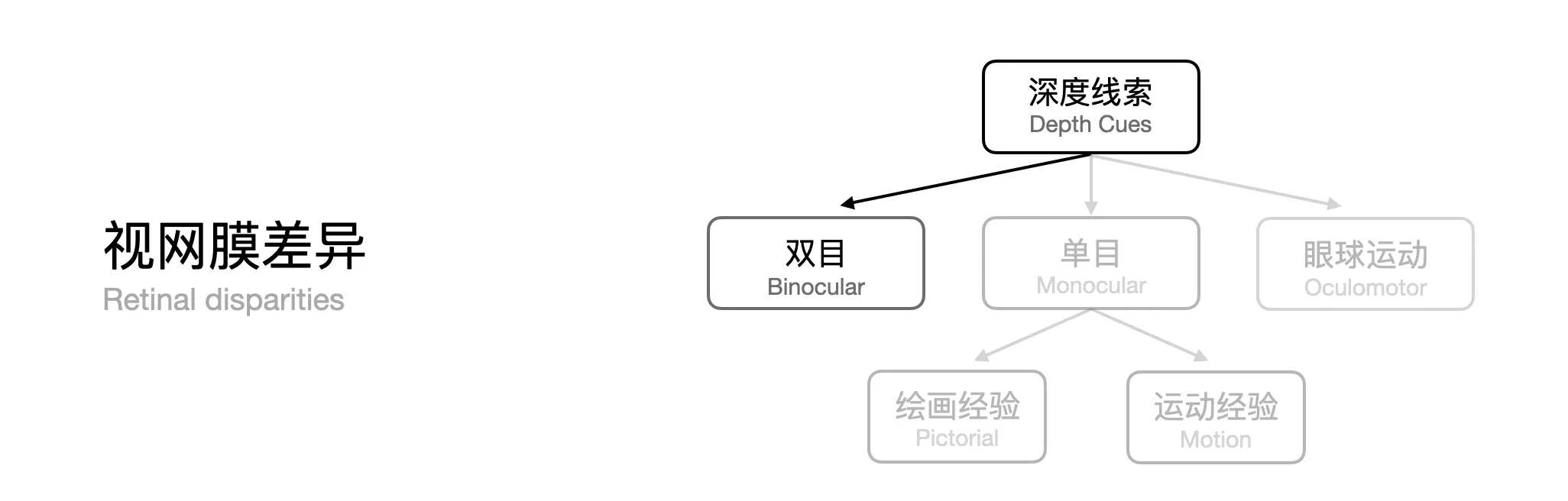

科普:为什么我们能感知深度?

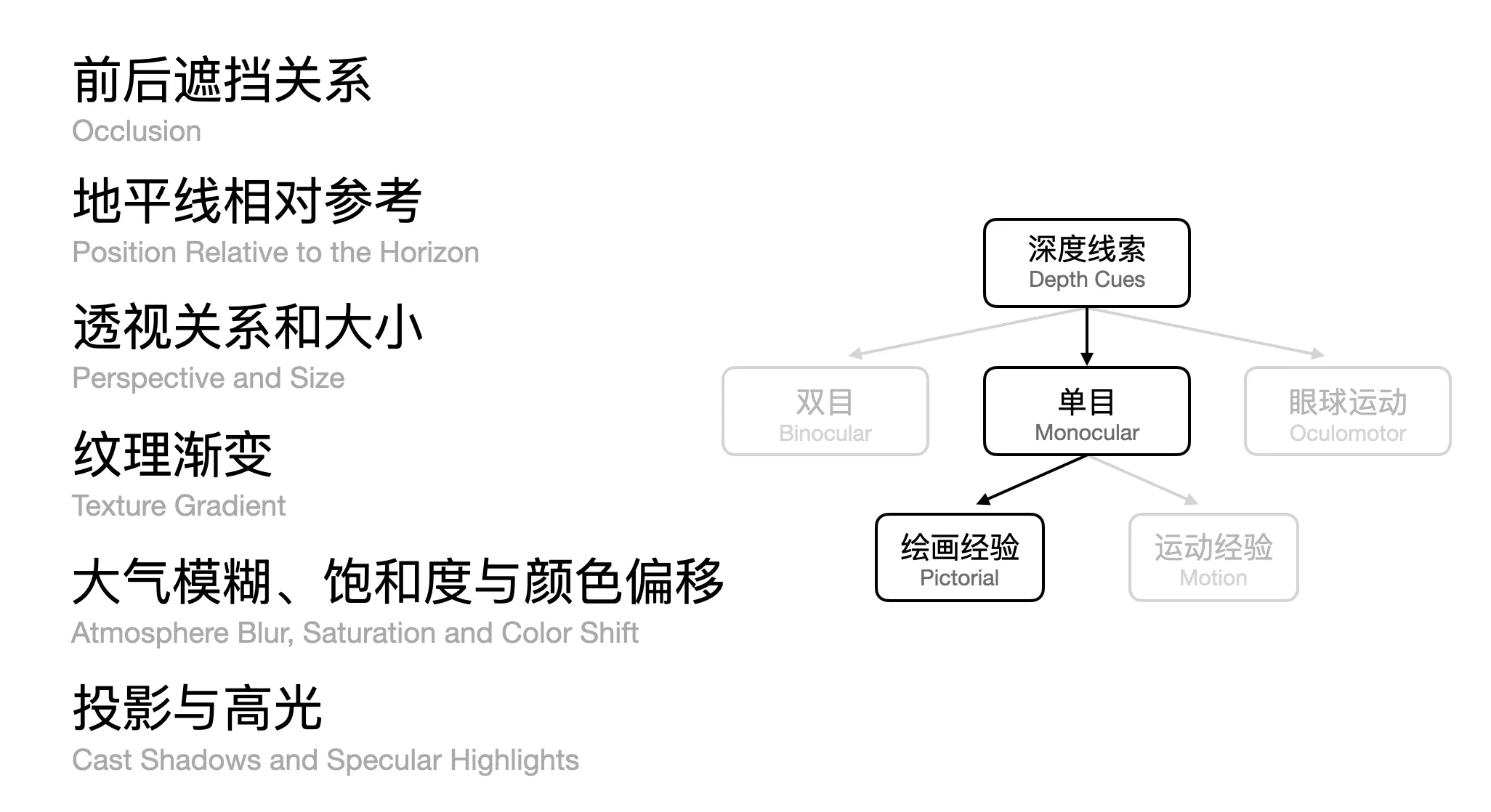

事实上,我们的视觉系统是通过使用各种复杂的线索,再通过大脑处理来推断深度。通常我们如果感觉空间视频缺乏立体感,大概率是拍摄的视频内容因其无法提供双目深度线索,而只提供了单目深度线索导致的。那什么是单目深度线索、什么是双目深度线索,以及我们的眼球是如何运动的呢?我们分别来了解一下。

单目深度线索

让我们先来看一些在绘画和摄影中被广泛应用的单目深度线索。所谓单目线索,是指从一只眼睛(摄影的角度就是从单个镜头)获取的信息。

在绘画中,这些线索已被人们总结并应用,例如:

- 前后遮挡线索。被遮挡的物体会被我们的大脑自然感知为更远,如下图中即便只有一张图,我们也知道被遮挡的戴黑帽子的选手离我们更远

- 地平线参考线索。如果画面中有地平线,那么地平线以下更靠近观察者,例如下图中的各种房屋

- 透视关系线索。正确的透视关系可以帮助我们感知远近关系。其中包括几何线索和纹理线索,例如下图中的房子,由于其呈现了 “近大远小” 的态势,我们就知道他离我们更远

- **纹理渐变大小。**类似物体的渐变会让我们能够明确这些物体的大小变化,例如下图中的郁金香,我们可以看到这些郁金香有的大有的小,因此我们根据这些纹理渐变就可以明确哪些郁金香是更近的

- 大小线索。我们的生活经验会让我们已知一些物体的大小,所以这些绝对大小是一个参考,例如下图中的蓝莓,由于我们知道蓝莓的正常大小,因此我们也可以知道这张图片中,蓝莓距离镜头非常近;另外相对大小也是重要的线索,比如若看到房子在画面中遮挡住了正常大小的人,那么这个房子大概率是一个放在镜头前的模型。

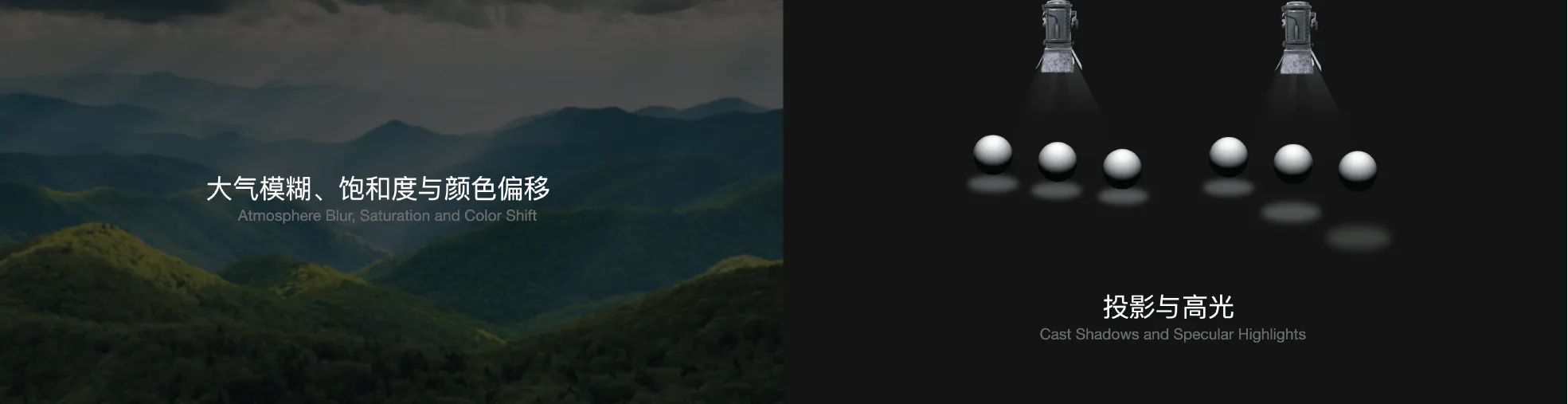

- 自然景观线索。一些自然景象也会被自动用来辅助我们感知深度。例如,层层叠叠的远山,通常看上去雾蒙蒙的,并且随着距离增加会发生颜色的偏移。

- 高光以及阴影。这也是帮助我们感知深度的重要线索,而且在平面界面中也被大量使用。

需要注意的是,如果一个画面中有多个线索,那么各种线索之间不能产生冲突。当然这是对绘画者的要求。在日常摄影中,我们通常不会遇到这个问题。

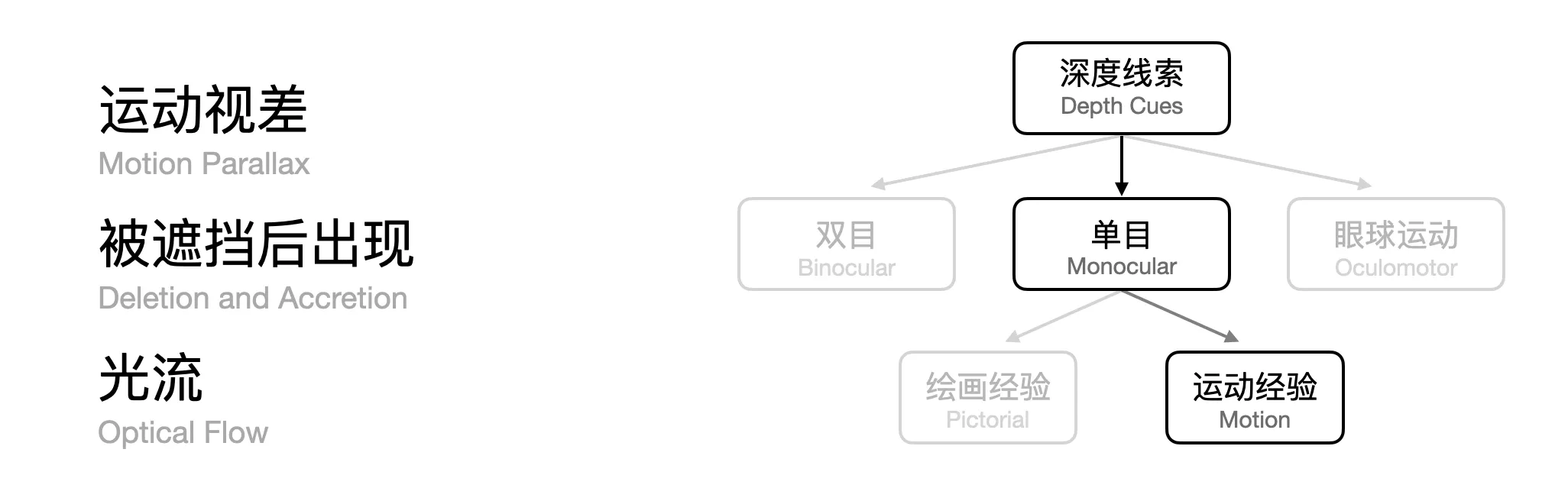

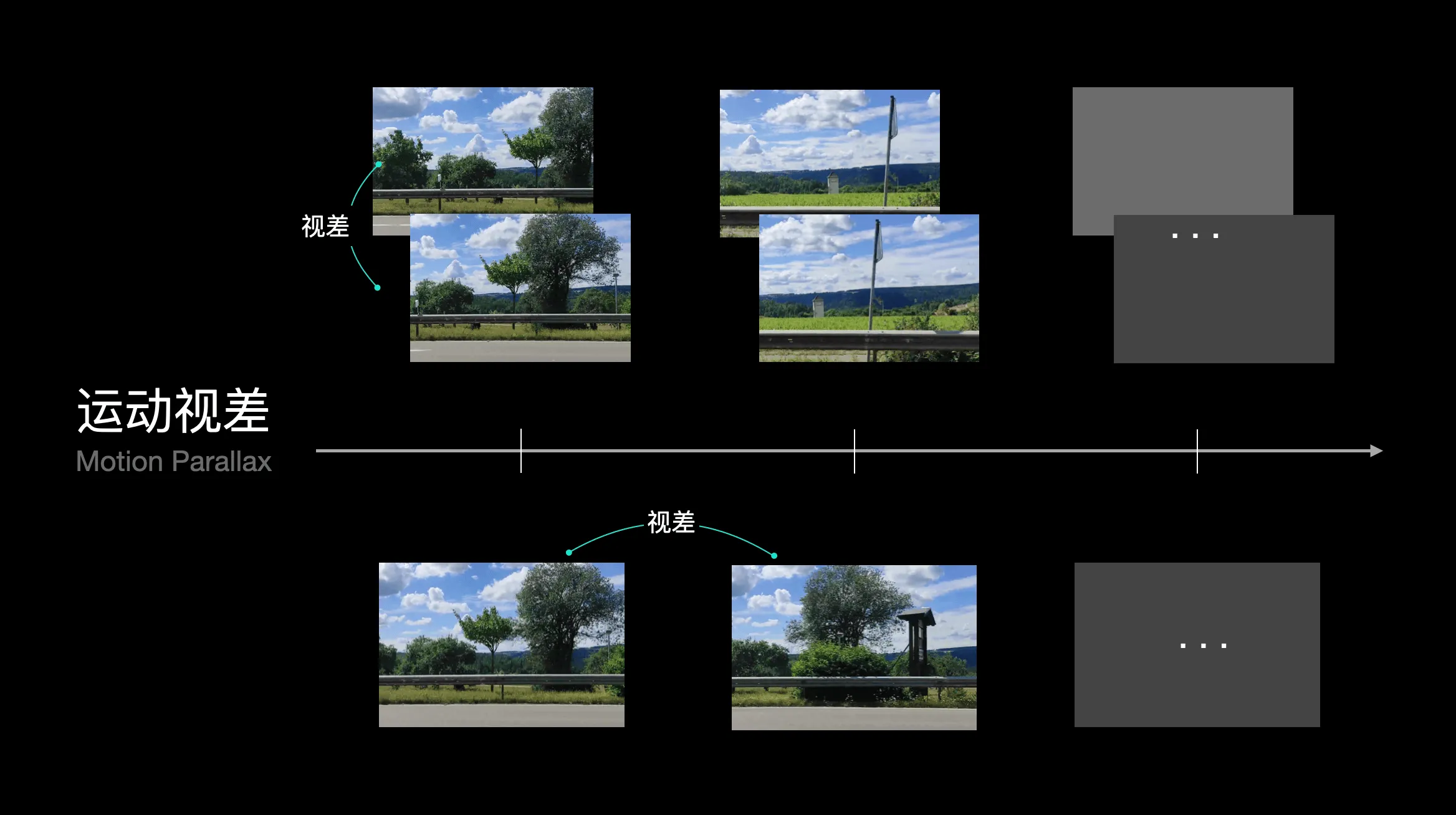

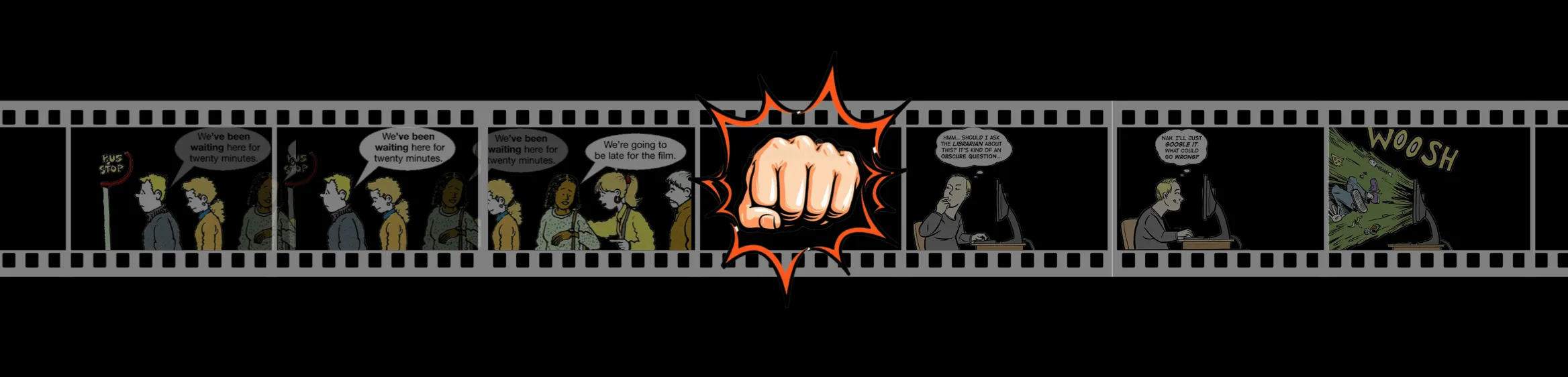

刚才我们讨论的基本都是绘画经验,所面对的都是静态场景,而在视频等动态场景则包含更多动态类型的深度线索,比如运动视差线索。其中根据移动的主体可以细分成到底是拍摄的相机在移动导致的视差,还是相机拍摄的物体在移动导致的视差,这两者对于我们感知深度没有太大影响,但是在拍摄空间视频的时候却会有一些差异。

另外运动视差其实从某种方面来说和双目视差类似,但是我们这里强调单目情况下,则更多说的是前后图像对比形成的视差,双目情况下某一时刻就可以直接根据左右图像判断出视差。

除此之外,还有遮挡后又出现线索。这和我们之前提到的遮挡关系提供的深度线索类似,比如视频里的小狗在树后跑,可以理解成连续图像下没有出现错误的深度线索。

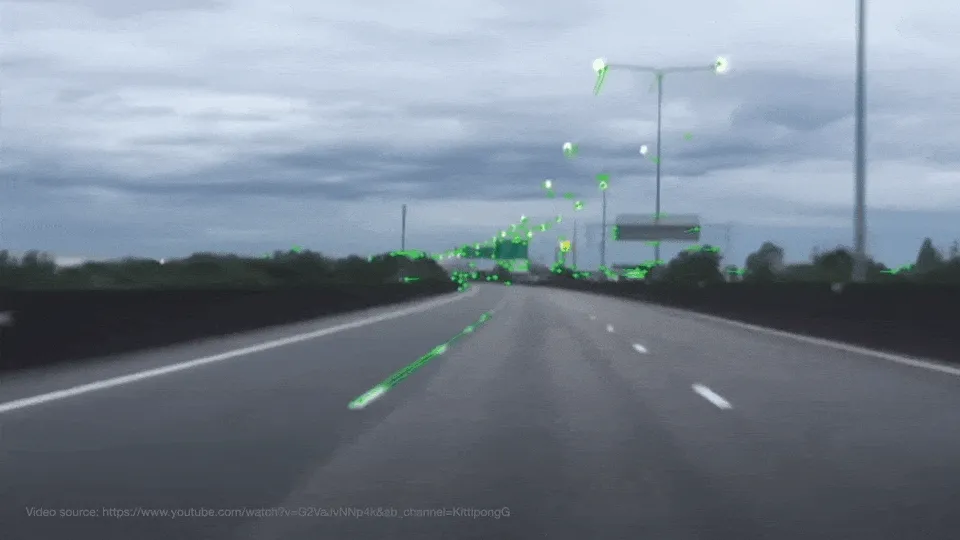

另外,在很多车载镜头上,我们可以看到光流线索。这种现象也是一种相对运动提供的线索,但是重点强调与观察者完全反向平行运动的物体所提供的线索,比如在高速公路上时候经常能看到四周的物体从视线向四周四散开。

因为运动视差提供的深度线索是我们人眼感知深度的主要参考之一,所以被广泛的应用在各种影视特效中,比如下面这段视频看上去是边开车边录制的,其实只是在一个静止的车内录制,最后为绿幕加上一个运动的背景制作出来。

所以说,想象一下,即使是在独眼海盗的世界里也是有三维的感知的,这也是为什么我们现在看手机、电脑、电视这些平面媒体也能感受到画面中的远近、深度、立体关系。但是我们的视觉系统能感知的线索远比上面介绍的要多。

眼球运动原理

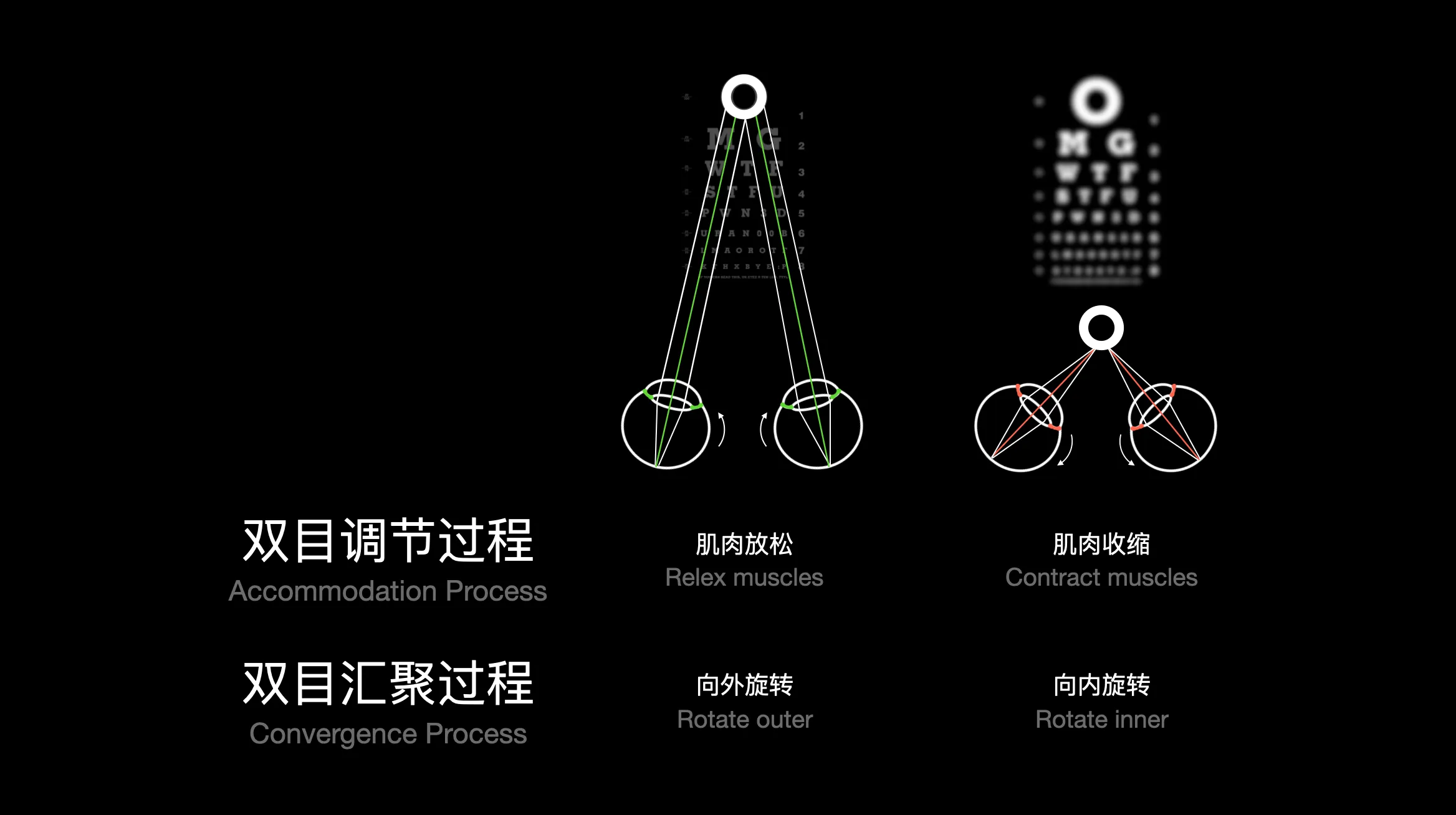

在介绍最重要的双目线索之前,我们需要先了解一下眼球的运动原理。

在现实生活中,我们的眼睛总是会有一个聚焦点的,当聚焦点比较近的时候,眼睛的睫状肌肉会收缩,聚焦点在远处的时候睫状肌肉就会放松。除此之外在看远看近时,眼球还会有额外的调节:那就是配合肌肉收缩向内向外旋转。

可以一起做个小实验,首先伸直你的手臂,举起你的一根手指,让自己的聚焦点聚集在手指上,然后从远慢慢靠近自己的鼻子。你发现了什么?是不是感觉周围的环境在慢慢的“模糊”?其实在眼睛进行调节的过程中,落在我们视网膜上的像不再是完全重合了(其中不重合也会有两种情况,具体是哪两种情况,马上就会介绍),这也是为什么我们会感到“模糊”。

利用这个注视点渲染的原理,我们也可以提出一个节约计算资源的有效技巧:即只在聚焦点渲染高清的内容,其他区域可以减低渲染精度。当然因为我们现在所有的 MR 设备的屏幕都是固定的,所以他只能模拟眼睛聚焦的固定距离范围,这里也为空间计算体验埋下了一个伏笔。

双目深度线索

了解了眼球的基本运动后,我们就可以进入最后也是最重要的一部分了,那就是双目线索部分。人的双目深度线索主要是通过具有一定内容差异的图像所提供的,我们的眼睛在接受到这些图像之后,大脑会自动处理,形成深度感知。

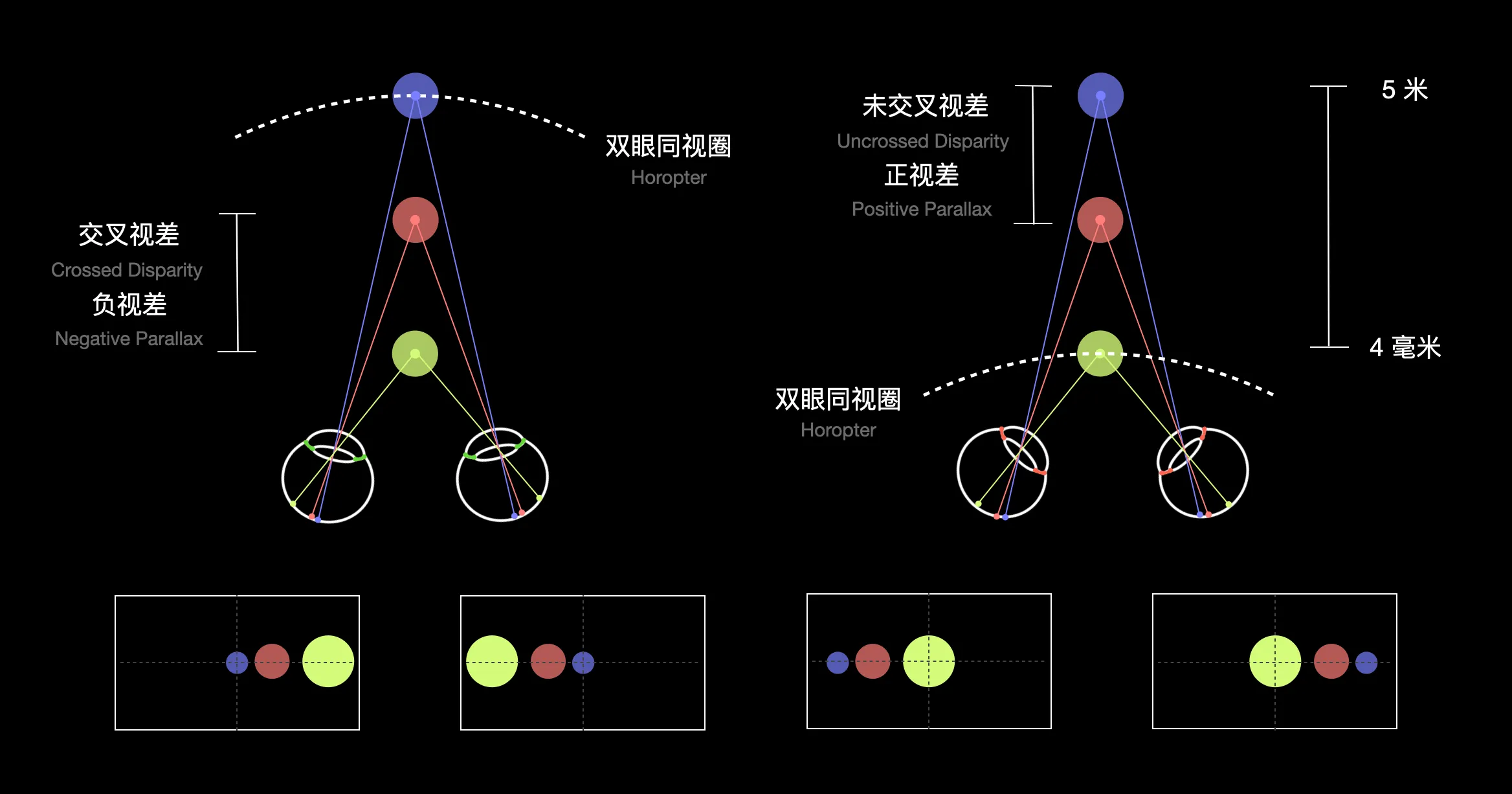

因为在拍摄空间视频的时候,摄像头一般是定焦的。我们假定其聚焦在紫色小球的区域(摄像机是处于眼球的位置)。相对于双眼同视圆靠近相机的区域,也就是黄色区域,一般称为负视差区域(或交叉视差区域),而如果我们假定其聚焦在黄色小球的区域,那么相对于双眼同视圆较远的区域(如上图右侧所示)就是正视差区域(或未交叉交叉视差区域)。

所以只要不在焦平面的物体,都会在成像平面出现视差,但是对于空间视频来说这两者有没有区别?答案是有的。一般来说,在正视差范围的物体,其成像虽然没有重合有视差,但是因为在双眼中呈现的是非交叉的像,所以只能提供单目线索,这也就导致在正视差区域内的立体感不会很强烈。

如何拍好空间视频?

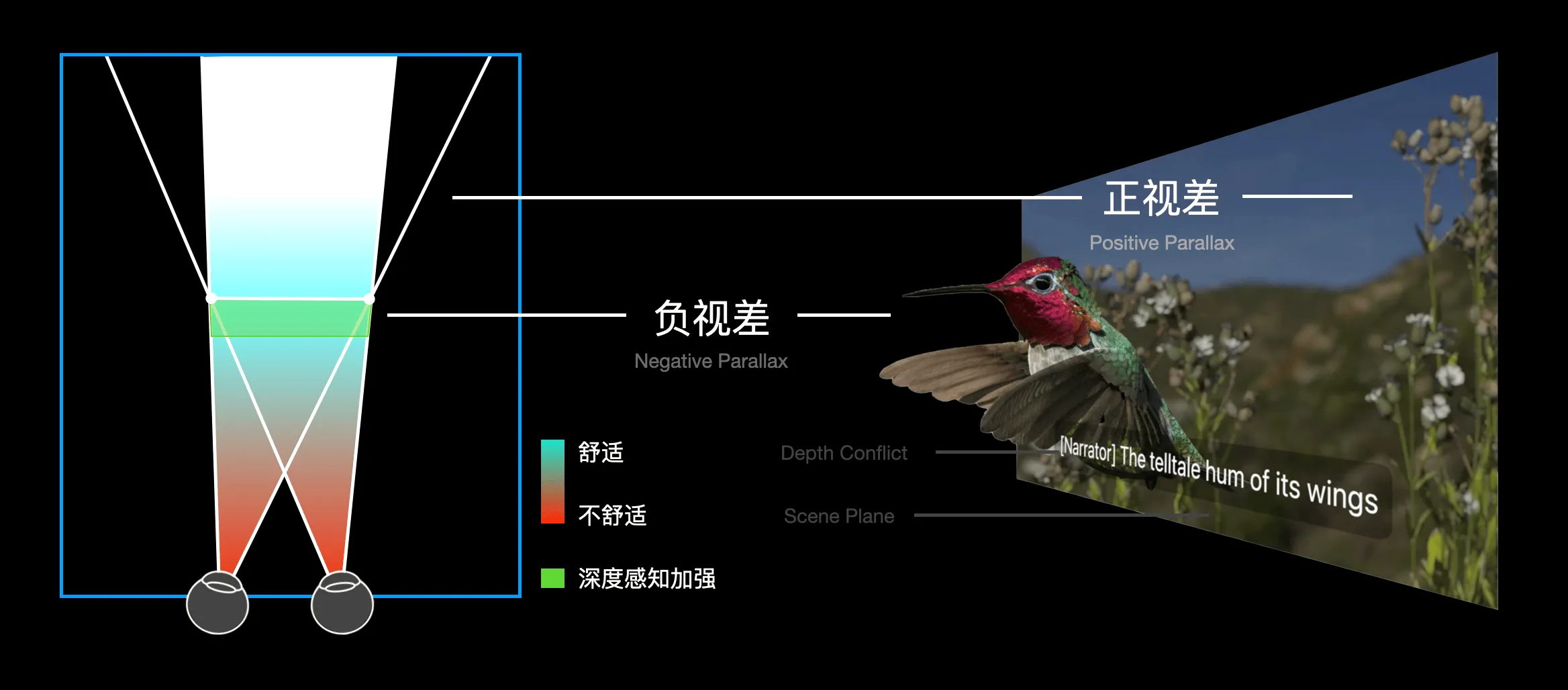

在使用 VST 技术的前提下,我们是透过显示屏幕去感知这个世界时,而又因为目前的 MR 设备屏幕都是固定的,相比我们眼睛的可调节范围,其实舒适的空间视频体验是被限制了的。当我们看较远的物体时,左右屏幕上呈现的图像视差是可以覆盖的,但是如果考虑极限的情况,这就好比我们把手指放到鼻子的位置然后努力去看我们的手指,我们就会变成斗鸡眼,那么太过于靠近目标物体的空间视频就会导致这个斗鸡眼现象。

所以理论上,立体视频有一个舒适的观看范围区域,对应的就有一个拍摄范围。一般来说呈现在负视差区域的物体我们能感受到直观的立体感,而处于正视差的区域就会退化到只能提供单目深度线索。

但是也不是所有负视差区域都是舒适的观看距离,如果太过靠近摄像头就会导致斗鸡眼现象。这也是为什么在用 iPhone 拍摄空间视频时候,手机会提醒不要离物体太近,我们也给大家分享了一些立体体验良好的空间视频,大家可以参看 B 站视频的这个空降地址。

那么大家可能要问了,我们一直在说合理的负视差范围,究竟合理的范围是多少?遗憾的是,这和具体的设备相关,我们调研了一些主流的,用于拍摄 VR 视频的双目相机,我们也总结了部分我们用过的设备的经验合适范围值,希望可以给大家一些参考。

注意:不要持续拍摄落在负视差内的物体

当我们观看平面视频的时候,我们也能感受到拍摄内容的远近关系,这是单目深度线索在起作用,所以这也是为什么我们说 2D 视频其实就是用一台摄像机拍摄的 3D 视频。我们知道拍摄的物体必须活动在合适的负视差区域,才能得到较好的立体观感,但是这显然限制了视频的创作。

我们建议在关键的时刻,比如介绍某个产品、展示某个特别的动作时候,通过运镜让目标运动在合适的负视差区域,反而能突出重点,虽然视频不是一直快要蹦出屏幕的体验,但却能降低观看过程中的持续视觉高负荷负担。

总结一下

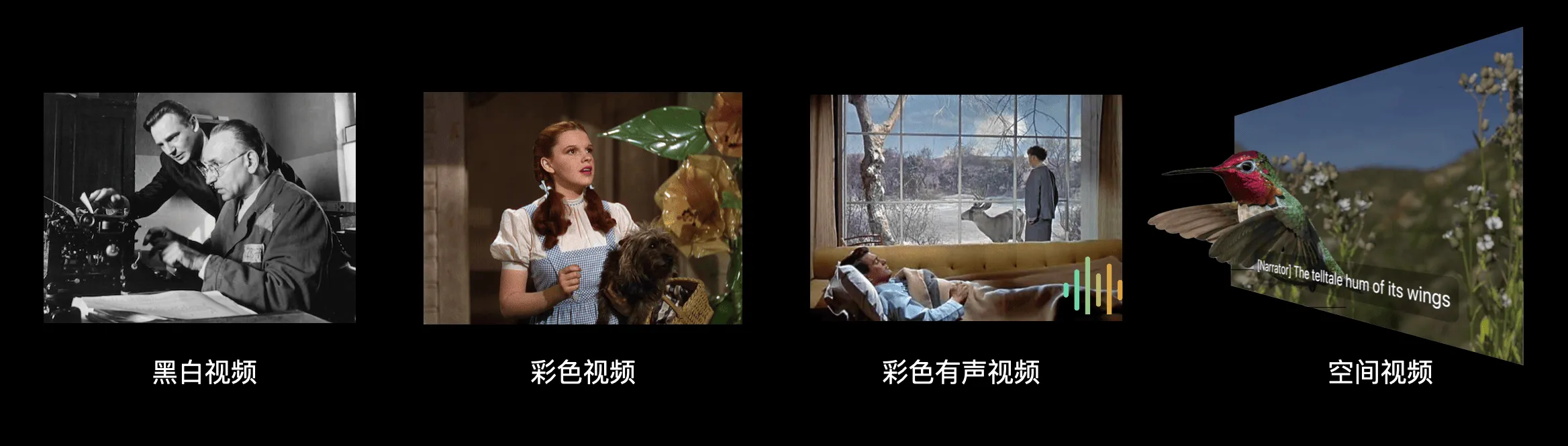

所以综合看下来,想要有一个好的,舒适的立体视频体验,要注意的地方还是有挺多的,其实回顾影视的发展,从最初的黑白电影,到彩色电影再到有声彩色电影,这些技术的进步都增强了对某一个感官刺激,而双目立体视频并没有超越现有的有声彩色视频对于感官的刺激。考虑到 Apple 的空间视频除了利用了双目视差,声音部分使用的空间音频也有不少加成,所以能够做到很好的体验也就不奇怪了。

另外值得注意的是,世界上还存在一小部分人群对立体的感知不敏感,所以放平心态,不要对空间视频有过高期待,就不会因为期望过高而失望。

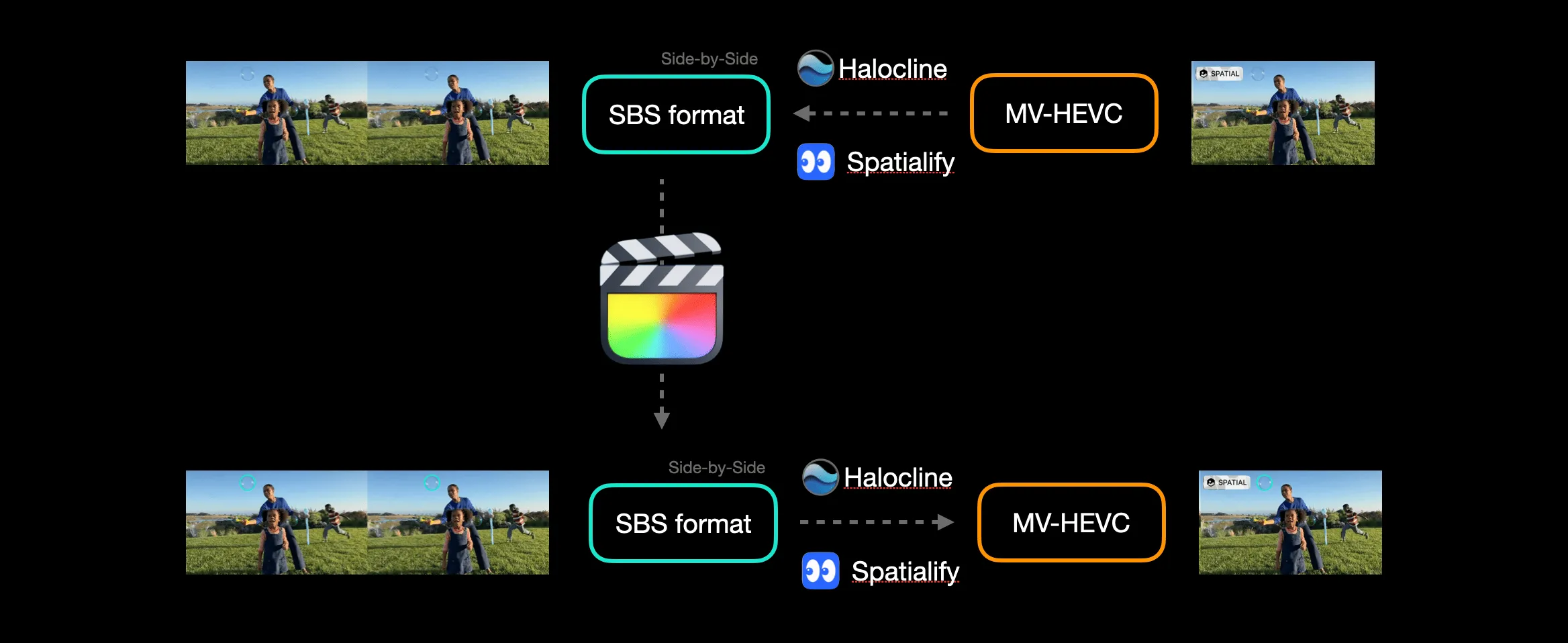

多说一点:如何编辑空间视频

最后我们来浅聊一下关于空间视频编辑的问题,目前还没有软件可以直接对空间视频进行编辑。当然我们可以利用一些工具将空视频解码到左右目的格式,然后进行编辑,编辑完成后再编码回空间视频。利用这步骤我们可以进行一些简单的处理,比如降噪、整体调色等等。

根据 外媒的报道,今年的某个时候 Apple 会给 Final Cut Pro 增加空间视频的处理能力。另外根据我们的内部消息,现在国内已经有团队开发了针对空间视频的编辑软件,会在 Apple Vision Pro 发布的时候同时上架。另外因为 MV-HEVC 是一种高效的编码格式,所以同等规格下拍摄空间视频并不会有太多的文件体积增加,所以后期处理也不会有太大的算力压力(如果你更新到了 iOS 17.3 Beta 2,首次打开拍摄时也会介绍空间视频录制的大小)。

非常期待即将发售的 Vision Pro,希望有一天我们真的能像哈利波特一样在冥想盆里分享、体验自己的、他人的立体回忆。

如果你对空间视频相关的话题有进一步的疑问或者想法,欢迎你关注 XR 基地的 公众号 并加入读者群与我们一起讨论~

附录:参考资料

- Stereoscopic 3D - Explaining the 3D movie experience

- Demystify VR180 - parallax issues, the workflow and techniques

- Deliver video content for spatial experiences

- Design considerations for vision and motion

- Sensation & perception 2nd Edition, Chapter 7

- Foundations of Sensation and Perception 3rd Edition

- 3D Movie Making: Stereoscopic Digital Cinema from Script

本文贡献者

| Link | Image |

|---|---|

| 章子飏 |  |

推荐阅读

- 细节解析 Meta Quest 3 在 MR 技术上的那些升级

- visionOS 2 PortalComponent - 更符合期待的传送神器

- 用渲染排序解决 RealityKit 中的透明物体嵌套问题 - 下篇

- 当 PICO 4 Ultra 碰上空间视频,会擦出什么火花? - 玩转空间视频,PICO 也很行!

- iPhone 15 Pro / Apple Vision Pro 上的空间视频,到底是什么?

- visionOS 手势匹配框架更新至 2.0,新增手指形状参数 - 让你在 visionOS 模拟器上也能使用手势追踪功能进行基础的手势测试

- 开源框架 RealityShaderExtension,帮你将 Unity 和 Unreal 的 Shader 转到 visionOS - 在 visionOS 上写 Shader 不再头疼

XR 基地

XR 基地